15 jun 8 tips om jouw crawlbudget te optimaliseren

Auteur: Erwan Vrignaud

Leestijd: 17 minuten

Iedereen denkt bij SEO aan een scala van technieken, maar het crawlbudget is een vrij nieuw fenomeen wat pas recent bij menig marketeer op hun to do lijstje is komen te staan. Het fenomeen crawlbudget is door Google in het leven geroepen om selectiever websites te kunnen indexeren vanwege de enorme hoeveelheid data die ze tegenwoordig moeten verwerken. En helaas ook veel troep wordt er iedere dag weer op websites geplaatst waarvan de makers denken dat het een toegevoegde waarde is voor zoekmachines of bezoekers, maar dat is vandaag de dag dus absoluut achterhaald. De algoritmes van Google worden steeds beter en effectiever in het negeren van content die niet relevant is en voornamelijk is ontworpen om zoekmachines te verleiden of misleiden. Is jouw website aangemerkt als een website die ook deze techniek gebruikt? Dan kun je daar allerminst blij mee zijn, het heeft gevolgen op je posities in de zoekresultaten. Zorg dus dat je website in orde is en als Google bij jou op bezoek komt alleen maar relevante pagina’s aantreft.

Hoe kun je dit het beste aanpakken? In dit artikel geef ik je 8 tips waarmee je kunt zorgen dat jouw crawlbudget zo goed mogelijk wordt ingezet.

Wat is het crawlbudget?

Zoekmachines gebruiken bots, ze worden ook wel spiders genoemd, om webpagina’s te indexeren. De twee bekendste bots zijn natuurlijk de Googlebot die nieuwe pagina’s ontdekt en toevoegt aan de Google Index, of de Bingbot, de bot van Microsoft. Veel SEO-tools gebruiken ook hun spiders om informatie te verzamelen en deze (al dan niet tegen betaling) toegankelijk te maken voor bezoekers. Vele platformen concurreren met elkaar, de ene is betrouwbaarder dan de andere. Tijdens het indexeren (crawlen) wordt informatie verzameld over deze website en worden deze informatie opgeslagen in hun database. Ook worden de inkomende links gedetecteerd. Dit is een indicatie van hoe andere websites een specifiek domein waarderen. Simpel voorbeeld: een grote website zoals nu.nl zal door veel andere kleinere websites worden “aanbevolen” doordat die kleinere websites links plaatsen naar artikelen die op nu.nl staan. Je kent ze wel, midden in een tekst staan dan zoiets als ‘Lees hier het laatste nieuws over XXXX (onderwerp)’ en door daar op te klikken word je doorverwezen naar nul.nl. Wanneer dit vaak genoeg gebeurt ziet Google dit als een belangrijke website. Maar een zzp’er die tuinier is en een kleine website heeft waar verder weinig activiteit is, daar zullen weinig tot geen links naar toe gaan. Een minder belangrijke website dus.

Het aantal keren dat een bot van een zoekmachine jouw website crawlt In een bepaalde periode is wat we het crawlbudget noemen. Aangezien Google iedere dag miljarden pagina’s moet indexeren kun je er dus van uitgaan dat Google niet iedere dag jouw website zal komen bezoeken. Gemiddeld gesproken indexeert Google jouw website iedere paar dagen tot een week. In Search Console van Google kun je zien wanneer Google voor het laatst bij je op bezoek is geweest. Je kan dit terug vinden bij Instellingen -> Crawlstatistieken. Hoe vaak Google langs komt hangt af van verschillende factoren zoals het crawlbudget.

Het verschil tussen SEO en crawlbudgetoptimalisatie

Al zijn beide onderwerpen nauw met elkaar verweven, SEO is een overkoepelende term die alle werkzaamheden bevat die er voor zorgen dat je website beter gepositioneerd wordt in zoekmachines en een zo goed mogelijke ervaring biedt aan gebruikers. Crawlbudgetoptimalisatie is alleen gericht op de zoekmachines om er voor te zorgen dat ze geen “tijd en energie” verspillen als ze jouw website bezoeken.

Hoe kun je dit zo goed mogelijk aanpakken? Ik ga je nu 8 tips geven die je zeker zullen helpen:

1. Zorg ervoor dat jouw pagina’s crawlbaar zijn

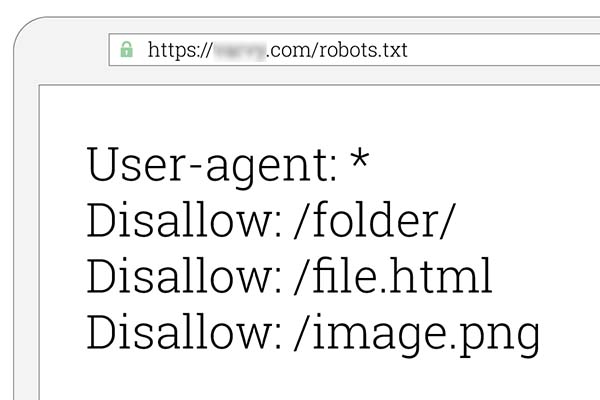

Jouw pagina is crawlbaar als spiders van zoekmachines deze kunnen vinden en volgen via de links in jouw website. Zorg er voor dat de .htacces en robots.txt bestanden niet jouw belangrijke pagina’s blokkeren, tenzij je dit per sé wel wilt. Het is overigens ook weer niet de garantie dat Google deze pagina’s dan overslaat, het is van jou een aanbeveling, maar Google kan deze mogelijk toch crawlen. Dit gebeurt vaak als inkomende links verwijzen naar een pagina die door jou is aangemerkt als ‘no-follow’. In dit geval moet je handmatig blokkeren dat de pagina geïndexeerd met behulp van de no-index robots meta tag of de X-Robots-Tag HTTP-header. Let er op dat tekst ook gelezen kan worden door zoekmachines. Maar al te vaak kom ik teksten tegen die verwerkt zijn in een afbeelding en dan worden ze niet gelezen. Tip: kun je de tekst met je muis selecteren? Dan wordt deze gelezen, zo niet, dan wordt de tekst niet herkend.

Robots.txt bestanden zorgen ervoor dat zoekmachines deze pagina’s overslaan

2. Pas op met rich media-bestanden

Rich-media bestanden zijn bestanden die vaak worden toegepast in advertenties om nog beter de aandacht van de bezoeker te trekken. Het betreft vaak een mix van audio, video of beeldbestanden die meerdere functionaliteiten hebben. Media bestanden kun je opsplitsen in twee hoofdcategorieën:

Standaard media: niet bewegende afbeeldingen met een grootte van max. 200kB met één klik-actie naar één bestemming

Rich media: al dan niet bewegende afbeeldingen die meerdere indelingen gebruiken (zoals video) met in de regel een grootte van meer dan 200kB met opties van verschillende vormen van interactie.

Vroeger had Google moeite met het lezen van JavaScript, Flash en HTML maar tegenwoordig is dat geen probleem meer. Maar als Google ze kan lezen betekent dat niet dat alle andere zoekmachines ze wel kunnen lezen. Wees hier dus selectief in.

3. Vermijd onnodige omleidingen

Elke URL waarnaar je omleidt verspilt een beetje van jouw crawlbudget. Als jouw website een flinke hoeveelheid omleidingen heeft, zoals de bekende 301 en 302 omleidingen, ben je mogelijk door je crawlbudget heen voordat Google alle bestemmingspagina’s überhaupt heeft bereikt. En dan worden de pagina’s waar het om draait dus niet meer geïndexeerd. Houd als stelregel aan: als het kan zo min mogelijk en niet vaker dan twee achter elkaar.

4. Repareer gebroken links

Vele experts (ook van Google zelf) hebben hier de nodige uitlatingen over gemaakt. Deze variëren van dat een gebroken link geen enkel effect heeft op organische ranking in de SERP (Search Engine Result Page) tot dat het funest zou zijn. Mijn advies is gebroken links wel degelijk op te sporen en te repareren en wel om de volgende 2 belangrijke redenen:

1. Ze belemmeren de pagina van jouw website te bereiken en dan kan deze ook simpelweg niet geïndexeerd worden.

2. Tegenwoordig is de UX-formule (User Experience) een steeds zwaarder wegende factor geworden, waardoor het niet meer dan logisch is dat als ook een bezoeker een link niet kan volgen dit toch zeker effect heeft voor je rankings.

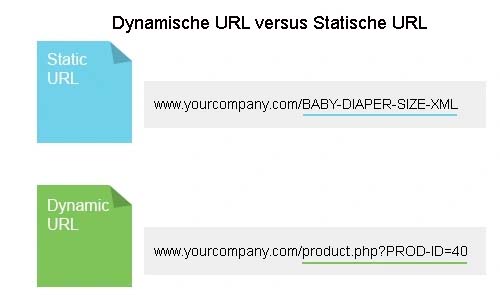

5. Gebruik geen dynamische URL’s

Dynamische url’s gebruiken speciale tekens (#%&^) en parameters en moeten worden vermeden omdat ze niet omschrijven waar de pagina over gaat. Hierdoor verspilt Google dus hun crawlbudget en zal deze pagina niet opnemen in hun zoekresultaten en minder vaak tot mogelijk niet meer opnieuw indexeren. Als je wilt weten of jouw url’s crawlbaar zijn kun je dit nakijken in Google Search Console: Instellingen -> crawlstatistieken.

Dynamische url’s hebben voor zoekmachines geen toegevoegde waarde

6. Je xml-sitemap opschonen

XML-sitemaps helpen de spiderbots van zoekmachines doordat het de content op jouw website hiërarchisch in kaart brengt. Probeer de sitemap up-to-date te houden en verwijder url’s die niet ter zake doen zoals; account logins, privicay disclamers, alle pagina’s met een 400 status, onnodige omleidingen, niet-canonieke pagina’s en geblokkeerde pagina’s. De eenvoudigste manier om jouw sitemap op te schonen, is door een tool te gebruiken zoals Screaming Frog. Deze brengt helder in kaart alle url’s die niet in orde zijn.

7. Zorg voor externe links

Linkbuilding is nog steeds een belangrijk onderdeel en het is de vraag of dit ooit zal verdwijnen. Het is vaker aangetoond dat relevante links zorgen voor een toename aan websitebezoeken. Belangrijk hier is te realiseren dat het beter is om één link te ontvangen van een gedegen website met een hoge autoriteit dan 100 websites met een lage autoriteit. Google hanteert hier wel een strikt beleid: het betalen voor links is niet toegestaan. Wees hier dus voorzichtig mee want vandaag de dag zijn de algoritmes steeds beter in het herkennen van betaalde links.

8. Maak interne links

Al speelt interne linkbuilding geen substantiële rol in de crawlsnelheid, dat betekent niet dat je kan het helemaal negeren. Een goed onderhouden sitestructuur maakt jouw content gemakkelijk vindbaar voor zoekbots zonder jouw crawlbudget te verspillen. Een goed georganiseerde interne koppelingsstructuur verbetert ook de UX (User Experience) doordat een bezoeker veel sneller kan schakelen in jouw website. De UX is tegenwoordig een steeds belangrijkere ranking factor en zoekmachines zien wanneer de UX hoog is, namelijk, er wordt een lange tijd op jouw website doorgebracht en er worden verschillende pagina’s bezocht die niet alleen via het hoofdmenu zijn bereikt. Hoe langer een bezoeker doorbrengt op jouw site, hoe beter.

Conclusie

Aangezien veel zoekmachines tegen hun grenzen aanlopen omtrent dataopslag en energie om alle content wereldwijd continue te indexeren, zal het crawlbudget een steeds grotere rol gaan spelen. Zorg dat je hier nu goed mee leert om te gaan en je zal er op de lange termijn de vruchten van plukken. Hoe makkelijker het is voor Google om jouw website te crawlen, hoe beter dit beloond wordt door betere posities in de SERP’s (Search Engine Result Page). Tegelijkertijd verbeter je hiermee ook de UX wat er voor zorgt dat een bezoeker langere tijd op je website doorbrengt. Vind je het lastig hoe je dit aan moet pakken? Neem contact op voor advies!