18 jul Hoe voorkom je duplicate content?

Auteur: Erwan Vrignaud

Lesstijd: 17 minuten

Een van de lastigste zaken met betrekking tot content is het feit dat veel relevante content in je website goed is voor je prestaties in zoekmachines, maar dat je zoveel mogelijk duplicate content (sterk vergelijkbare teksten) moet zien te voorkomen. Het is alsof je een Italiaans restaurant hebt en je menukaart mag niet te vaak pasta bevatten, ondoenlijk. En toch valt het in de praktijk mee. Als we de metafoor van het Italiaans restaurant gebruiken; zorg voor een duidelijk onderscheid in de pasta gerechten. Ga dus niet vijf soorten ‘Spaghetti met tomatensaus’ op je kaart zetten met het enige onderscheid de kruiden die zijn gebruikt. Dit wordt dan door zoekmachines te snel gezien als duplicate content omdat de verschillen minimaal zijn. Maar wanneer je 5 verschillende soorten spaghetti gerechten aanbiedt moet je deze apart vermelden; tomatensaus, knoflooksaus, truffelsaus, champignonsaus en kaassaus, ik noem maar wat. Dat zijn de verschillen dusdanig dat zoekmachines dit wel weer apart gaan labelen. Maar wanneer zien zoekmachines het nou als duplicate en wanneer niet? In dit artikel help ik je beter onderscheid te maken en hoe je duplicate content kunt voorkoen.

Meer content is niet per sé beter

Vaak heb ik gehoord dat men van mening is ‘Hoe meer content hoe beter’ en is dit in praktijk gebracht door enorme hoeveelheden content te plaatsen op hun website. Dit is absoluut niet waar en kan zelfs schadelijk zijn wanneer Google jouw website gaat zien als een SPAMMY-website. Dan heb je er dus enorm veel tijd en energie in gestoken om het tegengestelde te bereiken als wat je voor ogen had, je website zal slechter presteren in de SERP’s (Search Engine Result Page). Goed teksten schrijven is één ding, zorgen dat het voor zoekmachines zoals Google helder is waar het over gaat is een ander ding.

Er zijn twee soorten duplicate content en beide kunnen een probleem zijn:

Onsite duplicatie. Dat is wanneer dezelfde content wordt gedupliceerd op twee of meer unieke URL’s van jouw site. Dit is in de regel makkelijk te verhelpen door dit goed in kaart te brengen en de duplicate content aan te passen of te verwijderen. Na verwijderen nooit vergeten de url die je wilt verwijderen permanent door te leiden naar de andere pagina.

Offsite duplicatie. Dat is wanneer twee of meer websites exact dezelfde content in huis hebben. Dit is iets dat vaak kan niet direct kan worden verholpen, maar wanneer er contact gelegd kan worden met de eigenaren van andere websites is het handig te vragen of ze wellicht andere content van je zouden willen plaatsen. In goed overleg is veel mogelijk.

Met unieke content val je op, ook voor zoekmachines

Met unieke content val je op, ook voor zoekmachines

Waarom is dubbele content een probleem?

De beste manier om uit te leggen waarom dubbele content zo schadelijk is, is door het om te draaien: waarom is unieke content zo goed?

Unieke content is een van de beste manieren om jezelf te onderscheiden van andere websites. Wanneer de content op jouw website absoluut uniek is maak je gebruik van een bewezen marketingconcept, namelijk: het onderscheiden vermogen. In het voorbeeld van het Italiaans restaurant, wanneer je spaghetti aanbiedt met sausen die nergens anders te krijgen zijn, bijvoorbeeld spaghetti met zwarte truffelsaus, dit is (al ben ik ben geen culinair expert) hoogstwaarschijnlijk zeer zeldzaam vanwege de extreem hoge prijs van zwarte truffel, dan ben je onderscheidend en met dit uniek gerecht val je zeker op. Zo ook met zeer unieke content op jouw website.

Zoekmachines laten in hun resultaten url’s zien van verschillende websites die allemaal relevant zijn voor de bezoekers. Zoekmachines laten niet snel meerdere url’s zien van hetzelfde domein. Wanneer je dus op jouw website vaak over hetzelfde onderwerp schrijft, dan kiest Google een pagina uit en zal de rest negeren. Daar gaat je werk!

Of het nu onsite of offsite is, alle dubbele content concurreert met elkaar en het laatste wat je wilt is de concurrentie aan te gaan met jezelf. Maar wanneer je echt waardevolle en unieke content plaatst die op geen enkele andere url beschikbaar is, dan krijgt deze pagina maximale autoriteit. We gaan nu kijken hoe we dit probleem op kunnen lossen.

Offsite dubbele content

Offsite duplicatie komt vooral voor onder deze drie omstandigheden:

1. Content van anderen die je opnieuw hebt gepubliceerd op jouw eigen site. Dit komt het meeste voor in de vorm van generieke productbeschrijvingen die door de fabrikant geleverd is.

2. Jouw content die opnieuw is gepubliceerd op websites van anderen met of zonder jouw toestemming. Dit is komt het meeste voor bij nieuwsberichten, blogberichten en content die een hoge attentiewaarde bevatten.

3. Content die door zogenaamde scrapers automatisch van je website is gekopieerd en op allerlei andere sites wordt gepubliceerd. Dit zijn zonder meer de grootste overtreders in duplicaat content creatie. Spammers en cowboys die een verdienmodel hebben gecreëerd door, uiteraard tegen betaling, content te leveren die ze simpelweg van andere website hebben geript. En het vaak ook nog verkopen als unieke content. Of ze gebruiken de content om verkeer te genereren naar hun eigen site om bezoekers te laten klikken op hun advertenties. Helaas kun je hier niet veel aan doen, behalve een rapport in te dienen over auteursrechtschending bij Google in de hoop dat het wordt verwijderd uit hun zoekresultaten. Wanneer je vaak nieuwe content publiceert zou je hier zomaar een dagtaak aan kunnen hebben. Ondoenlijk. De beste manier om hier mee om te gaan, is door het te negeren, in de hoop dat Google kan het verschil ziet tussen de oorspronkelijke auteur en de ripper. Al worden de algoritmes van Google hier steeds beter in doordat ze bijvoorbeeld kunnen zien wie het eerste de content heeft geplaatst en zo dus weet dat iedereen die deze content daarna plaatst een ripper moet zijn, helemaal flawless zijn deze technieken helaas nog niet. Zo weten rippers soms hoe ze deze techniek kunnen omzeilen met trucs die ik hier natuurlijk niet ga vermelden. Een goede truc om deze rippers een hak te zetten is het al dan niet plaatsen van verborgen hyperlinks zodat zowel bezoekers als zoekmachines zien waar de content vandaan komt. Automatische ripsoftware heeft dit vaak niet in de gaten. Je kan ook proberen een canonieke tag terug te voegen naar de bronpagina (sowieso een goede strategie) zodat wanneer schrapers deze code kopiëren, Google in de tag kan lezen dat jij de originele schrijver bent.

Publicatie van artikelen

Wanneer een artikel van jou gepubliceerd wordt op een andere website zal de website eigenaar wellicht eisen dat je deze content nergens anders meer plaats. De reden is dat de website eigenaar weet dat de content op zijn website ook uniek moet blijven. Google is namelijk vaak in staat te zien wie de auteur van het artikel is en wanneer deze content (zelfs later) dan op de website van de auteur zelf wordt geplaats, is het zeer aannemelijk dat deze hoger in de zoekresultaten zal rangschikken. Maar ook dit is beperkt waar want er zijn meer variabelen die hiermee verband houden. Zolang de content maar niet op te veel verschillende websites belandt is er eigenlijk niet zo veel aan de hand. Het blijft dubbele content maar wanneer de relatie tussen de zoekintentie en de doelgroep van een bezoeker maar verschillend genoeg is, hoeft dit geen probleem te zijn. Voorbeeld; stel je verkoopt een nieuw type zaklamp die zeer specifieke eigenschappen heeft zoals een zeer brede lichtbundel. Als er twee keer dezelfde content wordt gelanceerd, maar de ene website gaat over nachtwandelingen in de natuur en de ander over hulpmiddelen voor ambulancepersoneel, dan is er zo’n groot verschil in zoekintentie en doelgroep, dat het elkaar niet zal bijten. Maar wanneer het onderwerp zeer specifiek is en voornamelijk gericht op één en dezelfde doelgroep, dan dien je wel voorzichtiger te zijn. Bij twijfel zal Google altijd kiezen om de url van de auteur prioriteit te geven.

Voor webshop vaak een enorme uitdaging om ervoor te zorgen uniek te zijn met hun artikelen

Dubbele content voor webshops

Veel online retailers verkopen exact dezelfde artikelen als duizenden andere winkels. In de meeste gevallen zijn de productbeschrijvingen verstrekt door de fabrikant, die vervolgens klakkeloos wordt geüpload in de database van de webshop en zo wordt gepresenteerd op de artikelpagina’s. Uiteraard verschillen de lay-outs van de pagina’s, maar zal het grootste deel van de content van de artikelpagina’s (de artikelbeschrijvingen) identiek zijn. Als je dit vermenigvuldigt over miljoenen verschillende artikelen met honderdduizenden websites die deze artikelen verkopen, dan is de conclusie snel te trekken dat er niet bepaald sprake is van originele content.

Hoe maakt een zoekmachine onderscheid tussen de ene of de andere webshop wanneer een zoekopdracht wordt ingevoerd? Puur op contentanalyse kan dat dus niet. Dat betekent dat de

zoekmachine naar andere signalen kijkt om te beslissen welke webshop voorrang zal krijgen. Een van deze belangrijke signalen zijn links. Hoe meer relevante links, hoe hoger de autoriteit van de webshop. Maar tegen grote webshop als Bol.com en Amazon is dit natuurlijk een verloren zaak. Dat wil niet zeggen dat je hier geen focus op moet hebben. Linkbuilding blijft een cruciaal onderdeel van SEO, mits wel correct uitgevoerd.

Een eenvoudigere manier voor webshops om onderscheidend te zijn is door de moeite te nemen om

unieke omschrijvingen te maken voor ieder artikel . Afhankelijk van het aantal artikelen die je aanbiedt kan dit een hele uitdaging zijn, maar uiteindelijk zal dit de geïnvesteerde tijd meer dan waard zijn.

Elke pagina met unieke content krijgt gegarandeerd meer waarde toegekend door Google dan sterk vergelijkbare of zelfs dubbele content. Het is misschien niet genoeg om je concurrentie te overtreffen, maar het is zeker de beste strategie om op te vallen voor zowel Google als bezoekers.

Onsite dubbele content

Technisch gezien behandelt Google alle dubbele content hetzelfde, of het nou op jouw website is of op die van anderen. Maar onsite dubbele content is kwalijker dan offsite omdat je zelf dit makkelijk kunt voorkomen en/of achteraf kunt oplossen. Dit negeren is niet slim. Het wordt meestal veroorzaakt door een slechte website-architectuur en/of ontwikkeling. Een sterke website-architectuur is de basis voor een sterke website. Het is cruciaal om de procedures te volgen die het voor zoekmachines makkelijk maken de website te indexeren. Dit negeren resulteert gegarandeerd in slechte resultaten in de SERP’s (Search Engine Result Page).

Laten we nu eens kijken veelvoorkomende problemen met betrekking tot dubbele content en hoe dit op te lossen.

• Het probleem: duplicatie van productcategorisatie

Veel te veel e-commercesites hebben last van dit soort duplicatie. Dit wordt vaak veroorzaakt door content management systemen waarmee producten per categorie worden geordend waarbij

één product in meerdere categorieën worden getagt.

Dit op zichzelf is niet slecht (en kan waardevol zijn voor de bezoeker), maar het systeem

genereert daarbij een unieke URL voor elke categorie waarin dit product voorkomt.

Als voorbeeld nemen we een bedrijf wat gespecialiseerd is in het vervangen van dakgoten. Op de website wordt verteld waarom EPDM (een soort rubber wat alle weersomstandigheden kan weerstaan) het beste is om te gebruiken. Maar deze belangrijke content staat op drie verschillende pagina’s:

Home > nieuwe dakgoot > epdm

Home > materiaalsoorten > epdm

Home > renovatie dakgoot > epdm

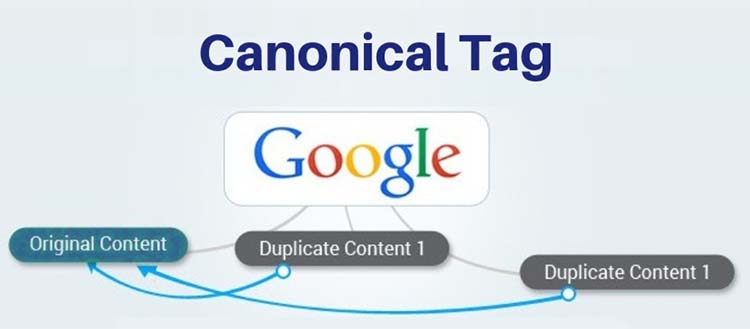

Dus dezelfde content is bereikbaar via drie verschillende url’s. Hoe los je dit het beste op? De beste manier is om de url waar het meeste verkeer naar toe gaat, of als de website nieuw wordt opgeleverd te bepalen welke url het belangrijkst is, deze de canonieke tag mee te geven. Zoekmachines herkennen dan weliswaar nog steeds dezelfde content, maar jij geeft aan welke dan het beste vertoont kan worden in de zoekresultaten. Dit is overigens geen garantie dat Google dit opvolgt, het is een aanbeveling waar Google rekening mee houdt.

Dus twee dingen zijn hier van belang:

1. Zorg dat de content van een pagina nooit voorkomt op andere pagina’s binnen hetzelfde domein

2. Zorg dat de content van een pagina überhaupt nooit voorkomt op een ander domein (een andere website)

Ik heb websites gezien tot tien verschillende URL’s hadden over hetzelfde artikel. Wanneer je dan 500 artikelen hebt, is het totaal aantal url’s ineens gegroeid tot 5.000 en daarvan zijn er dus 4.500 dubbel. Niet waardevol voor zoekmachines en niet interessant voor bezoekers, die denken dan al gauw: ‘Hé, die pagina had ik toch al gezien?’ en zijn mogelijk weer vertrokken. Probleem.

Als de website van de grootste concurrent in bovengenoemd voorbeeld ook 5.000 links zou hebben maar deze verwijzen allemaal door naar dezelfde pagina i.p.v. verschillende, dan is het niet moeilijk te begrijpen dat deze concurrent een vele betere algehele ranking zal krijgen. Zoekmachines beperken hun crawlbandbreedte zodat ze deze het beste kunnen besteden aan het indexeren van unieke en waardevolle content. Wanneer jouw site veel dubbele pagina’s heeft is er een sterke kans dat de zoekmachine stopt met crawlen voordat hij zelfs maar een fractie van jouw content heeft geïndexeerd. Het resultaat is dat honderden waardevolle pagina’s niet beschikbaar zullen zijn in de zoekresultaten.

De canonical tag is de meest gebruikte oplossing voor duplicate content

De twee beste oplossing:

1. de canonical tag

Omdat het niet altijd mogelijk is te vermijden dat meerdere verschillende url’s dezelfde content bevatten, is er een goede oplossing dit probleem op te lossen. De meest effectieve is de belangrijkste pagina te markeren met een canonieke tag (hierboven al even vermeld). Dit is vergelijkbaar met het selecteren van een hoofdcategorie en in WordPress is dit zeer eenvoudig mogelijk door in de Yoast PlugIn de pagina dit label te geven. Hiermee geef je aan Google door dat dit de belangrijkste pagina is gerelateerd aan dit onderwerp / artikel. Mocht je handmatig de code toe willen voegen in html dan ziet dat er als volgt uit:

<link rel=”canoniek” href=”https://www.home > nieuwe dakgoot > epdm” />

2. de no-index tag

In plaats van een canonieke tag te gebruiken om door te verwijzen naar de hoofdpagina is het beter de overige pagina’s te labelen met een noindex-metatag om ze op deze manier helemaal uit de index van zoekmachines te houden. Deze pagina’s kun je dan zien als weeskinderen omdat ze nooit vertoont zullen worden in zoekmachines, maar ze kunnen nog steeds wel bereikt worden door interne links. Wanneer deze ontbreken, dan heb je een boot die alleen ronddobbert in de grote oceaan en nooit land zal bereiken. Dan moet je deze pagina’s verwijderen en permanent doorleiden naar de hoofdpagina. Dit negeren maakt op den duur je website onnodig groot en zwaar voor je server wat weer effect heeft op o.a. je snelheid.

De canonieke tag is ontworpen om de paginawaarde en autoriteit over te dragen naar de hoofdpagina, maar omdat deze pagina’s toch geen unieke content bevatten kun je ze beter labelen met de no-index tag. Je doet daar zoekmachines een groot plezier mee.

Een veel voorkomende uitspraak van SEO “specialisten” is dat je penalty’s zou krijgen voor dubbele content. Dit is nonsens, dat is niet het geval. De pagina’s worden simpelweg genegeerd door zoekmachines maar dit kan wel als nadelig effect hebben dan belangrijke pagina’s wellicht ook worden genegeerd. Dus geen strafpunten, maar ook zeker geen bonuspunten. Google bestraft weliswaar niet dubbele content, maar dat betekent niet dat er geen nadelige gevolgen zijn die daardoor kunnen optreden.

Conclusie

Het beste advies dat ik kan geven is er voor te zorgen dat je website geen dubbele content bevat. Simpel zat. Het is misschien even wat werk dit grondig door te nemen, maar eenmaal gedaan zal het grote winst betekenen in organische prestaties. Uiteindelijk wil je een website bouwen die bekend staat om zijn sterke en unieke content en die content de best mogelijke waarde mee te geven voor je publiek en zoekmachines. Heb je hier vragen over of kun je hier hulp bij gebruiken? Neem contact op!